Tweet Sorry, this entry is only available in Japanese.

Category: laser

(日本語) TouchDesignerとBeyond両方でのタイムコードの扱い

Tweet Sorry, this entry is only available in Japanese.

(日本語) AUDIO GALAXY presents RAM RIDER LIVE2018 レーザー演出について

Tweet Sorry, this entry is only available in Japanese.

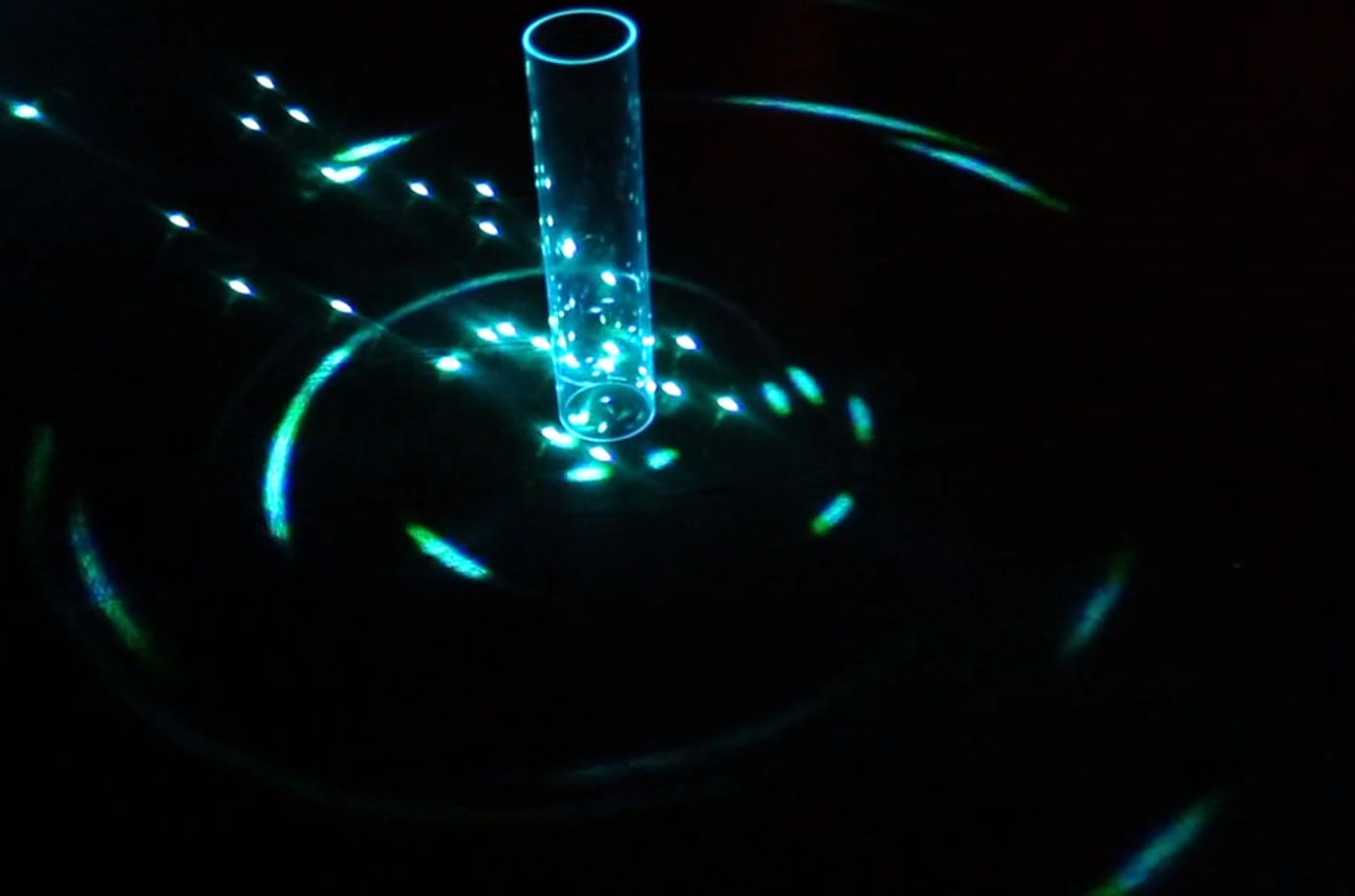

Mysterious effect by laser and camera

Tweet There is a mysterious laser effect that I was told by the person who work at movie company a few years a …

My first artwork, “hikarinami” was displayed at SmartIllumination 2017. And I got second prize!

Tweet Long time no see. In Nov.1-5th, 2017 “Smart Illumination Yokohama 2017″( http://smart-illumi …

(日本語) 頼朝の窟 2017

Tweet Sorry, this entry is only available in Japanese.

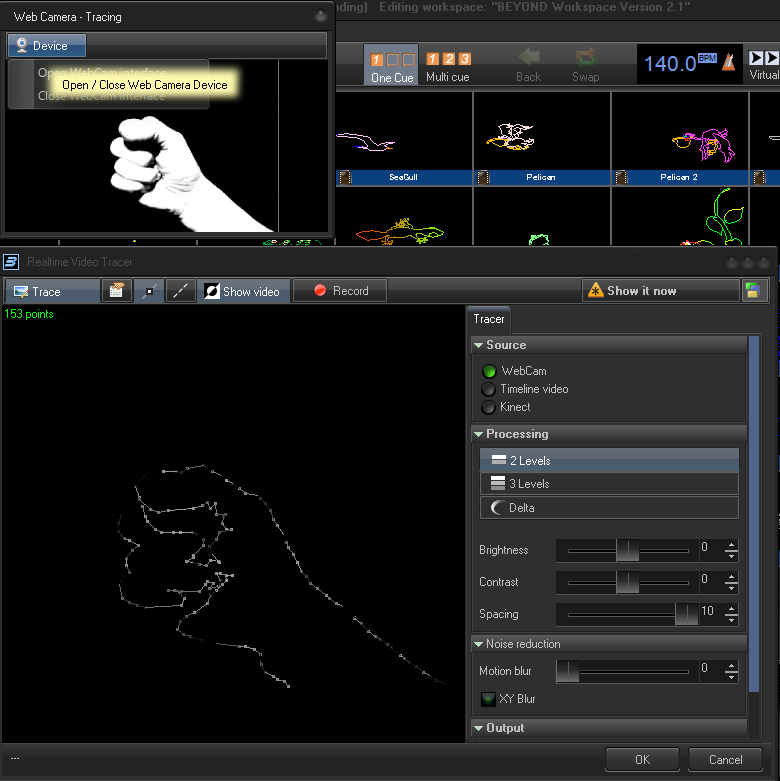

Realtime laser by Beyond

Tweet Like this video, I found the way to conevrt video to laser in realtime, so write this article. (I did it …

TouchDesigner+Laser

Tweet Recently I began to touch TouchDesigner. I do not get used to Node-based programming environment… …

(日本語) LASA安全管理責任者に合格しました。

Tweet Sorry, this entry is only available in Japanese.

developping laser control software

Tweet I’m developing software to control laser beam because I get laser-related jobs gradually. I want t …