Tweet レーザーを制御するソフト、Pangolin BeyondにはZoneという便利な機能があります。 これを使うと、「どの範囲に、どんな形状で、どんな風に」照射するかを指定することができます。 例えば、ビームで見 …

カテゴリー: laser

TouchDesignerとBeyond両方でのタイムコードの扱い

Tweet SMPTEなどのタイムコードを受信して、TouchDesignerとPangolin Beyond両方をコントロールする必要があったので、対応方法を書いておきます。 案1: TC4000経由でSMPTEをPa …

AUDIO GALAXY presents RAM RIDER LIVE2018 レーザー演出について

Tweet こちらの続きです。 http://hi-farm.net/detail/2018/09/09/audio-galaxy-presents-ram-rider-live2018/ ミラーを使ってイベントのロゴで …

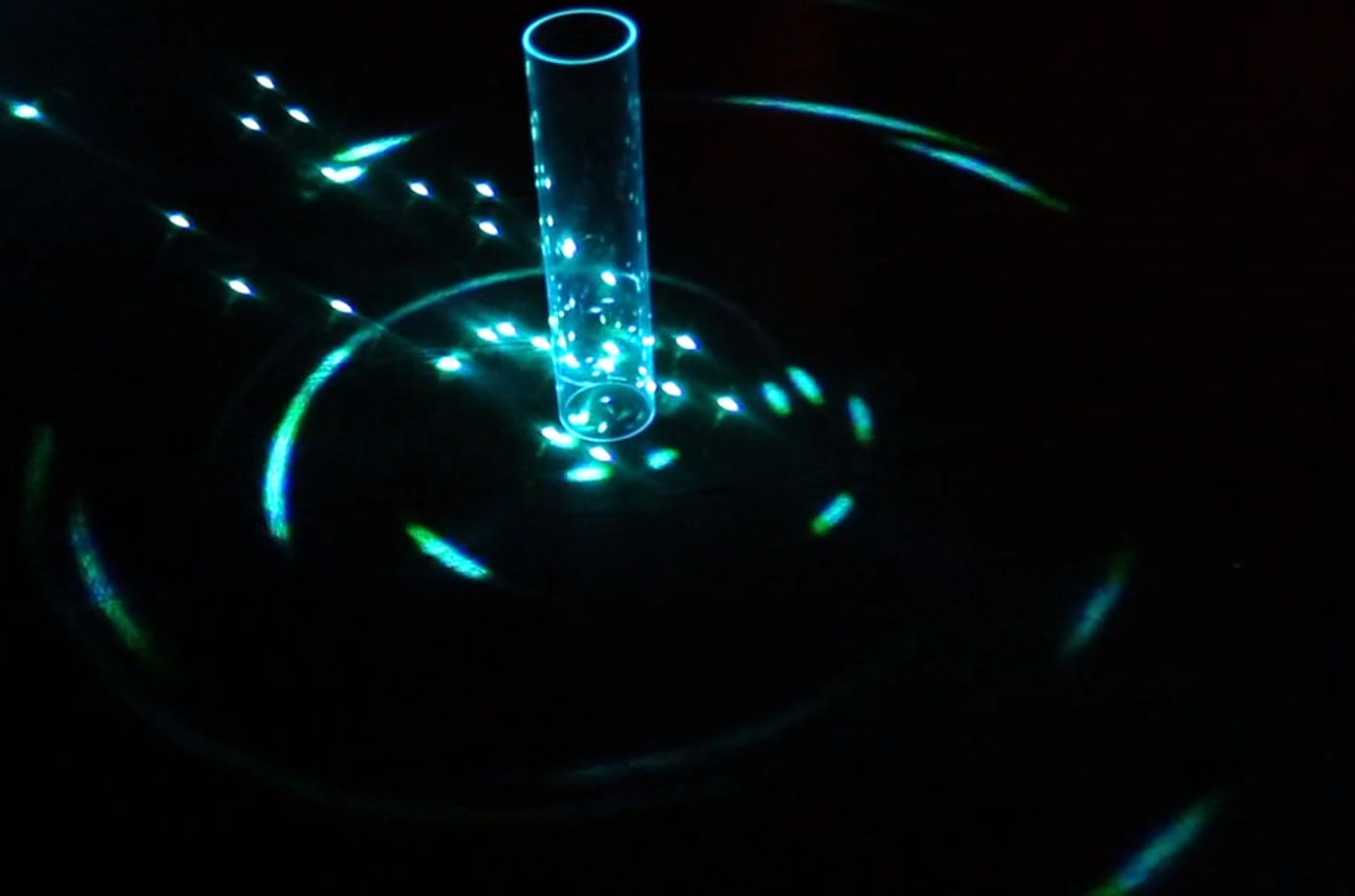

レーザーとカメラで行う不思議なレーザー演出

Tweet 数年前にとある映像会社の人から、「これどういう仕組みかわかります??」と言われていたレーザーの演出があります。 それがこちら。 “Welcome to the Youtube Music Awar …

光波(hikarinami)をスマートイルミネーションに展示、優秀賞をいただきました。

Tweet ご無沙汰しています。 突然ですが2017/11/1-5に横浜は象の鼻パークにて開催されていた「スマートイルミネーション横浜2017」( http://smart-illumination.jp/ )に、「光波 …

頼朝の窟 2017

Tweet ※イベントは無事終了しました。動画を追加します。 去年に続いて今年もやってきました。 湯河原町で開催されるプロジェクションマッピングのイベント。 今年はプロジェクションマッピングやレーザー、照明、音響に加えて …

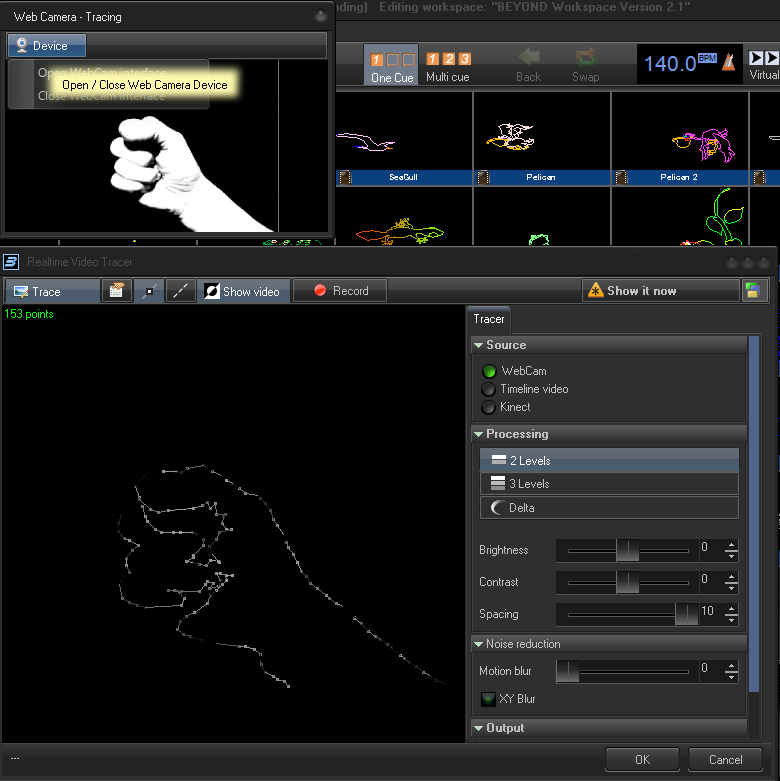

リアルタイムレーザー by Beyond

Tweet この動画のように、Pangolin Beyondでリアルタイムに映像をレーザーに変換する方法がわかったので記事を書きます。 (今までetherdreamでもやってきましたが、スキャナーのクオリティが思ったより …

TouchDesigner+Laser

Tweet 最近TouchDesignerを触り始めています。 ノードベースのプログラミング環境はどうもしっくりこず・・・ forループをどうするの?とか細かい条件分岐があった場合どうするの? Quartz Compos …

LASA安全管理責任者に合格しました。

Tweet ライブやエンターテインメントの場でのレーザー利用に関する認定資格であるLASA安全管理責任者の試験に合格しました。 この資格がないと使ってはいけない、というわけではないですが一定の知識があるという認定であるの …

レーザー制御ソフトを作っています。

Tweet こんにちは。 どうも記事をなかなか書かなくなってしまうのですが、最近作っているものを簡単に書いておきますね。 ここしばらく、レーザーやLED関連のお仕事が少しずつ増えていて、もちろん普通に演出パターンを考えて …