Tweet レーザーを制御するソフト、Pangolin BeyondにはZoneという便利な機能があります。 これを使うと、「どの範囲に、どんな形状で、どんな風に」照射するかを指定することができます。 例えば、ビームで見 …

Touchdesigner基礎 – ScriptCHOPのデータ量を調整する

Tweet 設定方法 ScriptCHOP内でnumSamplesの値を設定します。 あくまでScriptCHOP内で生成したものにのみ設定可能であり、inputs[0]などで参照したものを変更することはできません。 d …

TouchDesignerとBeyond両方でのタイムコードの扱い

Tweet SMPTEなどのタイムコードを受信して、TouchDesignerとPangolin Beyond両方をコントロールする必要があったので、対応方法を書いておきます。 案1: TC4000経由でSMPTEをPa …

TouchDesigner基礎 – scriptの動作を止めない方法

Tweet 私自身はプログラマなので、ノードでの対応方法はわからないか複雑だけどScriptだと簡単にできそうな場合はScriptで対応することがよくあります。 以前TouchDesignerを使っていたときにScrip …

[随時更新]TouchDesigner基礎(1)

Tweet ※このページは随時更新します。 基礎: ファイル形式 コンテキストメニュー。”Save Component .tox…”を選んで進めるとファイルとして保存できる。 Pale …

TouchDesignerでサブウィンドウを開くとフリーズする問題

Tweet 最近UE4を触ることが出てきてパソコンを買いなおしたところ、TouchDesignerでサブウィンドウを開くとフリーズする、という問題が発生していました。 メモリは64GBだし確実に性能は高いので問題はないは …

Openframeworks 0.9.8で作ったアプリが動かない場合

Tweet Openframeworksで作っているアプリを配布する機会があります。 今までは問題なく動いていたのですがインターネット経由で配布した時のみうまく動かない、という問題があってハマったので書いておきます。 開 …

Max/Msp・Unityを使って192chの音を制御するインタラクティブコンテンツを作りました。

Tweet webに載せている内容はレーザーを使った案件が多く、一見プログラミングやインタラクティブコンテンツの制作はやっていないんじゃないか・・・?と言われることが増えていますが、実際はバリバリ作っていますよ! ただ、 …

AUDIO GALAXY presents RAM RIDER LIVE2018 レーザー演出について

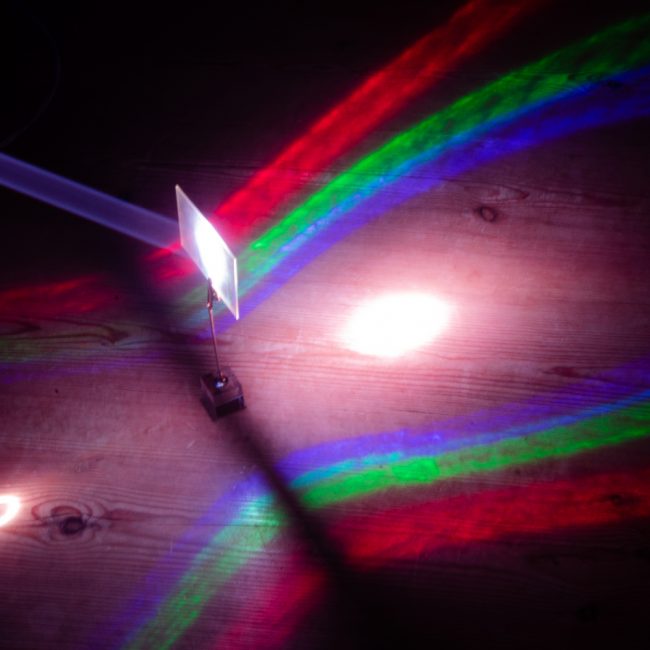

Tweet こちらの続きです。 http://hi-farm.net/detail/2018/09/09/audio-galaxy-presents-ram-rider-live2018/ ミラーを使ってイベントのロゴで …

名刺について

Tweet 昨年から使っている名刺について、「レーザーを当てるとエフェクトのように見える」という説明をすることが多い(光を扱う、という根拠があることをご説明するため)のですが、配布時にレーザーを持参していないことが多く、 …